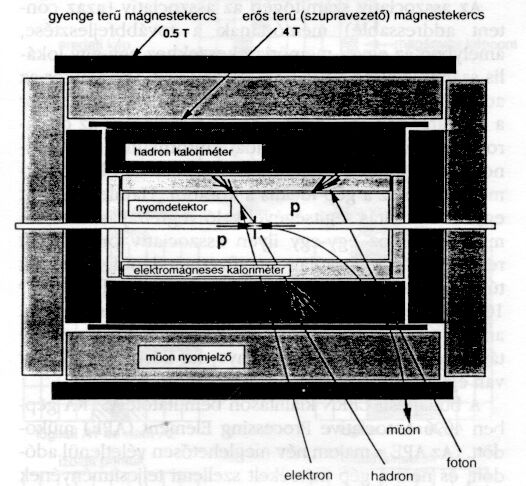

1.ábra. Ütközési kísérlet jellegzetes elrendezése

Fizikai Szemle honlap |

Tartalomjegyzék |

Vesztergombi György

MTA KFKI RMKI

Történelmi lecke

Könnyű volt Newtonnak és Galileinek a dinamika alaptörvényeit felfedezni, hiszen csak egy almafa alá kellett állni, hogy annak gyümölcse a fejére essen, illetve csak golyókat kellett lejtőn gurítgatnia vagy a pisai ferdetoronyból hajigálnia. Eltekintve attól a csekélységtől, hogy a megoldás előttük senkinek sem jutott eszébe, itt azt szeretném kiemelni, hogy az alapinformáció mindenkinek közvetlenül a szeme előtt volt. (Persze csak nézték, de nem látták.)

Ahogy azonban gyűlt az ismeretanyag, úgy vált egyre nehezebbé az újabb és újabb információ kibányászása. Gondoljuk csak el; hogy hány lépcsős folyamaton keresztül jutottunk el a Maxwell-egyenletekig.

Még lényegesebbet fordult a helyzet az atomfizika hajnalán, azt az alapvető és végtelenül "egyszerű" információt, hogy minden anyagforma az egyes elemek atomjaira vezethető vissza, a kémiai vegyülési szabályok, a kinetikus gázelmélet, Brown-mozgás stb. bonyolult összefüggéseinek tanulmányozása után, azaz csak sok-sok mellékes - ebből a szempontból zajnak tekinthető információ kiszűrése után lehetett levonni. Hogy ez mennyire jól sikerült, azt jól jellemzi az a tény, hogy jeles fizikusok még a 20. század elején is úgy nyilatkoztak, hogy az atomok létezése csak egy jó "munkahipotézis". (Zárójelben jegyzem meg, hogy a nincs új a Nap alatt jelszó jegyében, most ugyanez látszik lejátszódni a "kvark-hipotézis" szintjén.) Vagyis az atomot (legalábbis lelki szemekkel) lehetett látni, ha direktben nem is lehetett megnézni (persze a modern eszközök ma már erre is módot adnak).

Ahogy haladunk az atomfizikától a magfizikán át a részecske- illetve kvark-fizika felé a dolog úgy válik technikailag egyre nehezebbé és elméletileg egyre absztraktabbá (lásd kvantummechanika). Minél lényegbevágóbban értékesebb ez a tudásbeli kincs, annál vastagabb és vastagabb meddő fedőréteget kell róla lehántani. A 60-as évek során ahhoz, hogy egy-egy új elemi részecskét fedezzünk föl elég volt tíz-húszezer buborékkamra felvételt átvizsgálni, amit valóban emberi szemmel még végig lehetet nézni. De amikor a 70-es évek végén a SLAC-MIT kísérletben elektronokkal tapogatták le a proton belsejét, akkor a több millió kölcsönhatás regisztrálása és kiértékelése már csak a kor legmagasabb technikai színvonalán álló számítógépekkel volt lehetséges.

A negyedik (csábos = charmed) kvark felfedezéséhez S. Ting szintén számítógépeket használt, hogy több tízmilliós számú érdektelen "zaj-esemény" közül kiválassza az igazi új információt jelentő néhány százat. Állítólag az eredményen maga is annyira meglepődött, hogy alig mert hinni a szemének, ugyanis olyan éles csúcsot mutatott az invariáns tömegeloszlás, amelyre a korábbi adatok alapján nem volt semmi utalás. Ezért mintegy 3-4 hónapig habozott, hogy nyilvánosságra merje-e hozni.

Kevésbé volt habozó Carlo Rubbia, aki a CERN proton-antiproton ütköztetőn már két eseménnyel is ki mert állni a rivaldafénybe. Igaz, emögött is több éves kutatómunka állt, amely során több milliárd "zaj-esemény" kiszűrése után bizonyították a foton "nehéz testvéreinek", a W és Z részecskéknek a létét, igazolva ezzel az elektromágneses és gyenge kölcsönhatások Weinber-Salam által felírt egyesített elméletét.

A fejlődés azonban nem állhat meg. A kísérleti fizikusok újabb nagy kihívás előtt állnak. A Standard Modell szerint léteznie kell az úgy nevezett Higgs-bozonnak. Ennek felfedezésére épül Genfben a CERN-LEP alagútban, a már működő elektron-pozitron ütköztető felett a Large Hadron Collider (LHC), a Nagy Hadron Ütköztető. (Hadron a kvarkokból-antikvarkokból felépült barionok és mezonok gyűjtőneve, ezek vesznek részt az anyag erős kölcsönhatásaiban.) Itt azonban már olyan fantasztikus zajszinttel kell megküzdeni, hogy 10 16 proton-proton kölcsönhatás közül kell az egyetlen Higgs-bozont tartalmazó eseményt kiválasztani, vagyis ebből a szempontból a helyzet körülbelül 1 milliószor nehezebb, mint az a W, Z részecskék felfedezésekor volt. Ez a tény önmagában jelzi, hogy itt már az alkalmazott számítástechnika terén is valami újat kell nyújtani.

Osszd meg és uralkodj!

Hogy a modern számítógépeken még mit lehet újítani, azt egyszerű példán világíthatjuk meg. Legyen adva két tanár; az egyiknek az osztályában 40, a másiknak pedig csak egyetlen diák van jelen, mert a többieken kitört az iskolaundorral párosult influenza. Mindkét tanár ugyanazt a feladatott akarja megoldatni osztályával: Keressék ki a Hamlet eredeti szövegéből a híres "To be or not to be" sort. A sok diákos osztályban a tanár annyi darabra vághatja a szövegkönyvet, ahány diák van. Így minden diáknak csak néhány lapot kell átnéznie és máris megvan a válasz. Ezzel szemben az egy diákos osztályban nincs más választás, mint a drámát egyedül végigolvasva kell kikeresni a kérdéses sort, ami persze lényegesen tovább tart. (Eltekintve persze attól a kivételes esettől; ha véletlenül egy csodadiákról van szó, aki kívülről tudja a teljes szöveget.) Ezzel az "osszd meg és uralkodj" módszerrel, amelynek lényege, hogy minden diák (azaz minden párhuzamosan működő szá mítógép processzor) ugyanazt a feladatot hajtja végre különböző adatokon, a diákok (processzorok) számával arányosan felgyorsíthatjuk a teljes feladat megoldását. Az ilyen párhuzamos számítógép-rendszert Single Instruction on Multiple Data, azaz SIMD számítógépnek nevezzük.

1.ábra. Ütközési kísérlet jellegzetes

elrendezése

A SIMD-nél jóval bonyolultabb az a rendszer, ahol Multiple Instruction on Multiple Data (MIMD) módon történik a számítás. Erre jó példa a házépítés, ahol kőművesek, ácsok, burkolók, asztalosok, villany-, fűtés- stb. szerelők próbálnak lehetőleg együtt dolgozni, mindegyikük a saját programja szerint a saját anyagával egymást kiegészítve, sokszor egymást akadályozva. Szerencsére az ilyen MIMD rendszerekre a részecskefizikai detektorok igazán kritikus gyors reagálást igénylő részeinél nincs szükség, ezért elegendő csak a SIMD rendszerekre szorítkozni.

Az1. ábrán látható tipikusnak mondható LHC detektor sok-sok azonos modulra bontható, amelyek mindegyike adott számú detektorcsatornával rendelkezik. A Higgs-bozon felismerési feladat így egyszerre párhuzamosan végezhető az egyes modulokban, ahol a sebességet úgy tudjuk a végsőkig fokozni, hogy minden egyes érzékelő csatornához, amit detektorcellának is szoktak nevezni, egy-egy saját számítógépet rendelünk. SIMD rendszerű gép esetén ez viszonylag egyszerűen megtehető, mert csak egyetlen vezérlőműre (controllerre) van szükség, amely az akár 1 milliós számot is elérő egyedi processzorok közös utasításait generálja. Az ár sem jelent komoly problémát, mivel maguk a processzorok elég egyszerűek lehetnek és a modern chip-technológiával tömegesen gyárthatók. Tehát, legalábbis elvileg létezik technikai lehetőség ahhoz, hogy az LHC-hoz a párhuzamos szervezéssel biztosítsuk a fentebb jelzett milliószoros számító teljesítmény-növekedést.

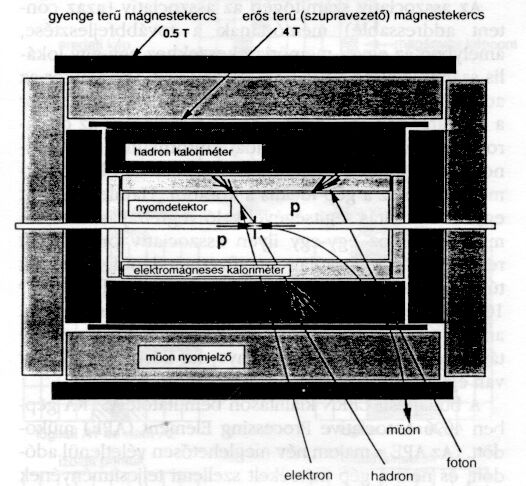

2.ábra. Bemenő jel / kiadott jel döntéshelyzet

Ikonból szimbólum

Azt, hogy egy adott proton-proton ütközésben keletkezett-e

Higgs-bozon, egyetlen szempillantás alatt kell eldönteni. Valahogy

úgy, ahogy a szemünket hirtelen be kell hunyni, ha valami (például egy szélfutta

porszem vagy bogár) repül feléje. A szemünkben a milliónyi érzékelő sejt (pálcika)

a bejövő képet (" ikon "-t) képpontokra (pixelekre) bontja és a mögötte

levő neuron-hálózat, mint megannyi kis SIMD rendszerben működő processzor

a kérdéses képrészt kiértékelve, leadja a vészjelet (a jelenség lényegét

tömörítő "szimbólum"-má alakítja). Az LHC kísérletben a detektorcellák

jelei felelnek meg a képpontoknak, ezek ikonszerűen elrendezett halmazából

kell a párhuzamosan működő sok-sok processzornak kivonni a szimbolikus információt

(2. ábra

), hogy ott egy "részecske-pálya", "elektron-szimbólum", "müon-szimbólum",

" -szimbólum" vagy kvarkot reprezentáló "rajszimbólum" volt észlelhető. Ugyanis

a Higgs jelenlétére abból tudunk következtetni, hogyezen szimbólumok milyen

kombinációban vannak jelen. Erre utalhat például, ha azonos invariáns tömeggel

több két "

-szimbólum" vagy kvarkot reprezentáló "rajszimbólum" volt észlelhető. Ugyanis

a Higgs jelenlétére abból tudunk következtetni, hogyezen szimbólumok milyen

kombinációban vannak jelen. Erre utalhat például, ha azonos invariáns tömeggel

több két " -szimbólumos" eseményt figyelünk meg, vagy 4 darab "elektronszimbólum"

(illetve "müon-szimbólum") jelentkezik egyszerre, míg a "raj-szimbólumok"

zömmel csak háttérzajnak felelnek meg.

-szimbólumos" eseményt figyelünk meg, vagy 4 darab "elektronszimbólum"

(illetve "müon-szimbólum") jelentkezik egyszerre, míg a "raj-szimbólumok"

zömmel csak háttérzajnak felelnek meg.

Asszociatív gondolkodás

Az LHC kísérletekre való felkészülés jegyében a CERN-ben az MPPC projekt (Massively Parallel Processor Collaboration) keretében elkészült az ASTRA párhuzamos számítógép, amely projektben az OTKA 3271-es téma által nyújtott támogatás segítségével magyar fizikusok is résztvettek. A gép neve az ASP System Testbed for Research and Application kifejezés rövidítéséből ered, ahol a hangsúly az ASP betűszón van, amelyet tovább kifejtve Associative String Processor adódik. Ugyanis az ASTRA lényege, hogy egyetlen kommunikációs szálra ("string"re) felfűzött processzorok asszociatív logikával működnek benne. Az asszociatív logika lényegét újra csak egy szemléletes példán keresztül érzékeltethetjük, ahol a szokásos szekvenciális logikával szembe állítva rögtön kiugrik az alapötlet.

Vegyük egy világváros milliónyi előfizetőt tartalmazó telefonkönyvét. Ebben az információ a nevek szerint szekvenciálisan rendezett formában került rögzítésre, így könnyen megtalálhatjuk egy adott személy telefon számát, viszont nagy bajban vagyunk, ha a szám ismeretében próbáljuk a telefontulajdonos nevét vagy lakcímét megtalálni. A normál szekvenciális gépen erre nincs más mód, mint sorról-sorra végig menni, míg eljutunk a keresett számot tartalmazó sorhoz, ami egy millió szám esetén átlagban félmillió lépés után vezet eredményre.

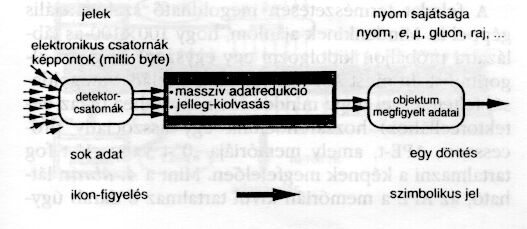

3.ábra. ASP párhuzamos gép általános architektúrája

Asszociatív logikájú gép esetén ehhez csak egyetlen utasításra van szükség, mert itt megfordul a kérdés: ahelyett, hogy arra keresnénk feleletet, hogy hányadik sor tartalmazza a keresett információt, az összes sorban egyszerre megnézzük, benne van-e a keresett szám, vagyis a kérdés így módosul: van-e olyan sor, amelyik tartalmazza az adott számot. Számítógépesebb nyelven ez azt jelenti, hogy a szokásos memóriák esetén az egyes memóriarekeszek címe (address) szerint szelektálunk, azaz címenként ellenőrizzük a tartalmat (content), míg az asszociatívan szervezett memória esetén rögtön a tartalomra kérdezünk (content addressing), és így a megfelelő memóriarekeszt címzés nélkül azonosítjuk. Vegyük észre, hogy a memóriával mindkét esetben csak egyetlen számot közlünk, vagyis a bemenő információ mennyisége lényegében azonos, csak az értelmezése eltérő. Persze a tartalomra csak akkor van értelme kérdezni, ha az valamilyen értelemben már előre definiált, ezért a kétféle gondolkodásmód nem mindig cserélhető fel egyszerűen. Mindkét logikának megvan a maga optimális felhasználási területe.

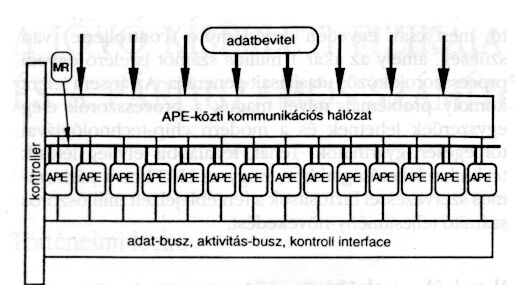

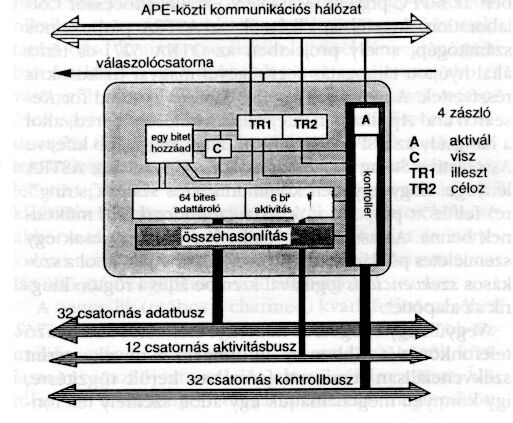

4.ábra. Asszociativ adatfeldolgozó egység

Az asszociatív számítógép az asszociatív (azaz content addressable) memóriának a továbbfejlesztése, amelyben az egyes memóriarekeszekhez egy-egy lokális számítóegység ("CPU") is csatlakozik, így amikor az adott memóriarekeszben megvan a keresett szám, akkor a hozzárendelt számítógép képes feldolgozni az ott tárolt többi információt is, például informálhat a tulajdonos nevén kívül a házszámról, foglalkozásról stb. Természetesen ez a gép ideális a korábbi "Hamlet" feladat egyetlen utasítás segítségével való végrehajtására is, ha minden sorhoz egy-egy ilyen asszociatív processzort rendelünk. Ez látszólag megfizethetetlenül drágának tűnik, de ma már viszonylag könnyen realizálható akár 16 ezer processzort tartalmazó párhuzamos gép is, amelybe soronként egy processzort véve egyszerre betároíható egy 500 oldalas könyv, ha körülbelül 30 sor van egy oldalon.

A budapesti CERN kiállításon bemutatott ASTRA gépben 4096 Associative Processing Elemem (APE) működött. (Az APE = majom név meglehetősen véletlenül adódott, és nem a gép mérsékelt szellemi teljesítményének fokára szándékozik célozni.) Az Angliában a Brunel Egyetemen R.M. Lea professzor vezetésével kifejlesztett ASP párhuzamos gép általános architektúrája a 3. ábrán látható, míg az egyes processzorok (APE-k) elvi rajzát a 4. ábra mutatja.

Az ocsútól a búzát

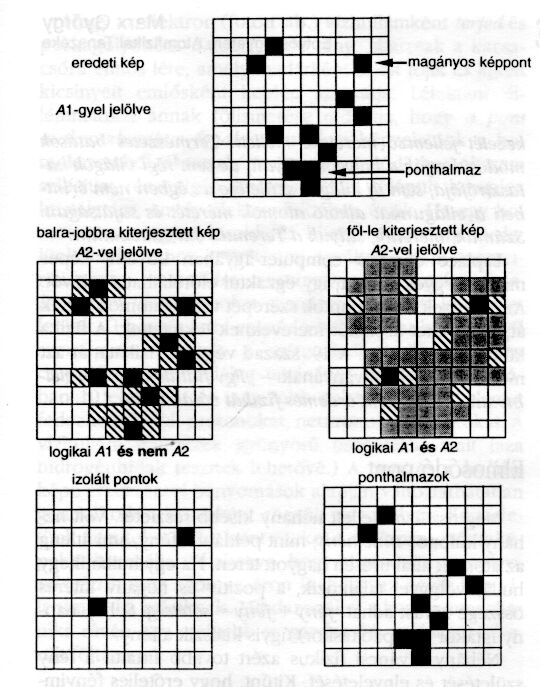

Annak szemléltetésére, hogy milyen effektív lehet az asszociatív módon való programozás, vegyünk egy a kísérleti helyzetet jól reprezentáló, de a fölösleges részletektől mentes példát. Tegyük fel, hogy van egy négyzetrácsba rendezett érzékelőket tartalmazó detektorunk (ilyen lehet például egy elektron-kaloriméter). Ha igazi részecske halad át ezen detektor felületén, akkor az általa kiváltott jel legalább 2 szomszédos érzékelő cella állapotát változtatja a "0" helyzetből "1"-re, amelyek a képi ábrázolásban összefüggő foltként (cluster) jelennek meg. Sajnos a valóságos kísérletben a detektorcellák nemcsak akkor szólalnak meg, ha részecske halad át rajtuk, hanem a külső és belső zavarok hatására véletlenül is az "1"-es állapotba kerülhet egy-egy érzékelő. Mivel a fizikus számára csak a részecskék által okozott jelek érdekesek, ezért először azt kell gyorsan megállapítani, hogy mely pontok tartoznak a zajhoz. Vagyis matematikailag az a feladat, hogy egy négyzetes bináris táblázatban azonosítsuk az izolált "1"-ket és töröljük ki. Egy lehetséges példát mutat a 5.ábra fekete kockákkal jelezve az "1"-ket.

A feladat természetesen megoldható szekvenciális géppel is. Mindenkinek ajánlom, hogy 100 X 100-as táblázatra próbáljon kidolgozni egy egyszerű és gyors algoritmust. Itt most ASP-vel vázoljuk a feladat megoldását feltételezve, hogy minden kis négyzethez (azaz detektorcellához) hozzárendelünk egy asszociatív processzort, APE-t, amely memóriája "0"-t vagy "1"-et fog tartalmazni a képnek megfelelően. Mint a 4. ábrán látható, az APE a memórián kívül tartalmaz 6 darab úgy nevezett activity bit-et: A1, A2, ...,A6. 3. A 3. ábrán jelzett vázlat alapján az egyes processzorok információt tudnak egymásnak átadni. Ezen körülmények ismeretében az asszociatív program lépései a következők:

5. ábra. Elemi példa párhuzamos adatfeldolgozásra.

Egy-képpontos háttérzaj kiküszöbölése

6. ábra. Nagy Hadron Ütköztető (LHC) jelzésadó

stratégiája

Az algoritmussal kapcsolatban nagyon fontos megjegyezni, hogy mindig az adott APE tartalmára történt a hivatkozás, amely teljesen független attól, hogy igazából összesen hány processzor van, azaz az 1000 X 1000-es kép esetén is ugyanannyi lépésből állna a program!

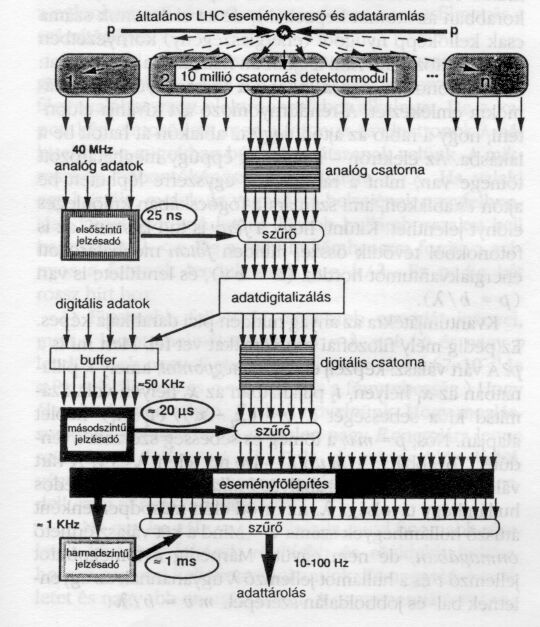

LHC kísérleti stratégia

Az LHC kísérleteket nemcsak számítástechnikailag, de a

tényleges fizikai kiterjedésben is extra méretek jellemzik. A tipikus detektor

átmérője 20 méter, hossza 30 méter, súlya 30000 tonna, és ez a mintegy hatemeletes

háznak megfelelő építmény elektronikus érzékelő csatornák tízmillióival lesz

megtömve. Az időátlagban nanomásodpercenként (10-9 s) egy kölcsönhatást

produkáló proton-proton ütköztető berendezés közvetlen jeleit még a fentebb

említett szuper párhuzamos digitális számítógépek sem tudják megemészteni

(6. ábra

), ezért a legelső szinten ("First-level-trigger") csak úgynevezett

"bedrótozott" fénysebességgel működő "analóg-logikát" lehet alkalmazni. Az

intelligencia a második szinten ("Second-level-trigger") lép be, hol mintegy

20  s-nyi gondolkodási idő áll rendelkezésre. Itt lesz a fentiekben leírt

típusú párhuzamos számítógépek ideális helye. Ezt követheti a finomabb végső

analízis ("Third-level-trigger"), amelyhez már milliszekundumok állnak rendelkezésre,

és amely már a közönséges univerzális számítógépekkel is elvégezhető. Így

a fizikusoknak ténylegesen "csak" a másodpercenként kiválasztott néhányszor

tíz eseménnyel kell a továbbiakban törődniük. Még ez se könnyű, hiszen egy

évben több, mint 107 másodperc van! A részecskefizika eddigi fordulatos

történetének ismeretében ebben a hatalmas anyagban biztos számíthatunk számos

igen váratlan felfedezésre, így a CERN-nel együttműködő magyar fizikusok az

elkövetkező 10-20 évben biztos nem fognak unatkozni.

s-nyi gondolkodási idő áll rendelkezésre. Itt lesz a fentiekben leírt

típusú párhuzamos számítógépek ideális helye. Ezt követheti a finomabb végső

analízis ("Third-level-trigger"), amelyhez már milliszekundumok állnak rendelkezésre,

és amely már a közönséges univerzális számítógépekkel is elvégezhető. Így

a fizikusoknak ténylegesen "csak" a másodpercenként kiválasztott néhányszor

tíz eseménnyel kell a továbbiakban törődniük. Még ez se könnyű, hiszen egy

évben több, mint 107 másodperc van! A részecskefizika eddigi fordulatos

történetének ismeretében ebben a hatalmas anyagban biztos számíthatunk számos

igen váratlan felfedezésre, így a CERN-nel együttműködő magyar fizikusok az

elkövetkező 10-20 évben biztos nem fognak unatkozni.